In Zeiten von steigendem Kosten- und Wettbewerbsdruck ist es wichtig, die richtigen Entscheidungen im Unternehmen schnell und proaktiv zu treffen. Business Intelligence bildet die Basis für brauchbare Daten. Data Science in Verbindung mit Predictive Analytics ermöglicht es Unternehmen, detaillierte Einblicke in Ihre Daten zu gewinnen und Zukunftsprognosen zu erstellen.

Seit den letzten Jahren wachsen Künstliche Intelligenz (KI) und Data Science zu Trendthemen heran: 84 Prozent der Entscheidungsträger aus IT und Management geben beispielsweise an, dass der Einsatz von KI einen wettbewerbsentscheidenden Faktor darstellt.

Allerdings fehlt in der Praxis häufig die nötige Expertise, um aus der Vielzahl der Daten die richtigen KI-Anwendungsfälle zu identifizieren und umzusetzen. Dabei liegt die Schwierigkeit vor allem darin, zuverlässige und strategisch relevante Vorhersagen zu treffen.

Welche Entscheidungen möchten Sie zukünftig datengestützt treffen? Diese Frage ist essentiell, denn um langfristig und erfolgreich einen Mehrwert sowie Wettbewerbsvorteile aus Ihren Daten zu generieren, benötigen Sie eine Data-Science-Strategie. Gemeinsam mit Ihnen erarbeiten unsere Expertinnen und Experten in einem interaktiven Workshop das Fundament für Ihre individuellen Data-Science-Projekte und konstruieren erste Use Cases.

Wurde ein konkreter Use Case identifiziert, egal ob dieser auf strukturierten oder unstrukturierten Daten basiert, unterstützen wir Sie bei der Durchführung des Proof-of-Concept sowie bei der Entwicklung eines Minimum Viable Products (MVP). Entscheiden Sie sich in diesem Kontext für unser adesso-Result-as-a-Service-Angebot, können wir Ihren Use Case auch komplett für Sie umsetzen.

Zusätzlich bieten wir Ihnen durch individuell auf Ihr Unternehmen angepasste KI-Schulungen die Option, Data-Science-Kompetenzen in Ihrem Unternehmen aufzubauen. Hier liefert adesso Ihnen einen Überblick über Use Cases, notwendige Skills und Technologien. Damit Ihre Mitarbeiterinnen und Mitarbeiter danach ideal vorbereitet sind, kann die Schulung direkt mit Ihren Daten durchgeführt werden. Dabei haben Sie die Wahl. Welche Programmiersprache für Sie und Ihre Mitarbeitenden geeignet ist, entscheiden Sie selbst.

Gemeinsam mit Ihnen analysieren wir in einem Interaction Room Workshop die für Ihr Unternehmen passenden Use Cases und legen die entsprechenden Rahmenbedingungen fest. Während des Workshops wird ein gründliches Verständnis der Geschäftsidee, der vorhandenen IT-Struktur, der Datenstruktur und -qualität sowie des Informationsgehalts der Daten entwickelt. Basierend darauf entwerfen unsere Expertinnen und Experten einen passenden Umsetzungsplan sowie eine geeignete Architektur- und Technologieauswahl.

Beim Prototyping geht es um Geschwindigkeit. Das Ziel besteht darin, möglichst schnell die Funktionalität und Umsetzbarkeit des entwickelten Konzepts zu evaluieren. Um dies zu erreichen, wird eine geeignete Datenmenge zur prototypischen Entwicklung des intelligenten Algorithmus genutzt. Gerne informieren wir Sie in diesem Zusammenhang auch rund um das Thema Datathon.

Wie erfolgt der Rollout, kommt eher Batch- oder Stream-Processing in Frage oder wie wird die Qualität des Produktes überwacht? Das Ziel der Operationalisation besteht darin, diese Fragen zu beantworten und den prototypisch entwickelten Use Case in eine unternehmensweite Plattform zu integrieren – sozusagen vom Proof-of-Concept zum Data-driven-Produkt.

Ist die Problemstellung Ihres Unternehmens durch KI lösbar? Welche Herangehensweisen sind möglich, welche Daten stehen zur Verfügung? Welche Technologien und Konzepte können eingesetzt werden? Wie wird aus einem Prototyp ein fertiges Produkt? Um Data-Science- und KI-Projekte strukturiert und zielführend umzusetzen, haben wir ein Konzept entwickelt, das in drei Phasen gegliedert ist.

Vor der Durchführung des zweitägigen Workshops ist es in einem ersten Schritt zunächst notwendig, vorhandene IT-Strukturen, Datenstrukturen, Datenqualität und Informationsgehalt der Daten zu eruieren. Der IR:analytics vereint die BI-/DWH-Expertise mit Ihren Fachbereichen und sorgt von Anfang an für eine optimale Kommunikation und einen regen Austausch. Während des Workshops werden folgende Punkte geklärt:

Basierend auf den Ergebnissen des Workshops wird ein grundlegendes Konzept entwickelt, um zu ermitteln, welche Architektur, Technologie, welche Daten und welche Methodik zur Datenaufbereitung sowie zur Umsetzung der identifizierten Use Cases am besten geeignet sind.

Der zweite Schritt beinhaltet das Prototyping mit dem Ziel, möglichst schnell Use Cases zu testen. Hier beginnt die agile, prototypische Implementierung der ausgearbeiteten Ergebnisse. Basierend auf priorisierten Backlogs erfolgt eine stufenweise Implementierung in Sprints.

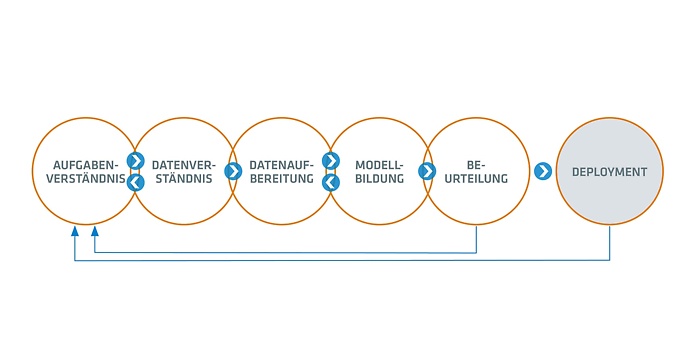

Um die Strukturierung von Aufgaben, die Reproduzierbarkeit und Objektivität der Implementierung zu gewährleisten, kombiniert adesso in Data-Science-Projekten agiles Vorgehen mit dem CRISP-DM-Prozess. Der Prozess durchläuft in der Regel mehrere Iterationen. Nach jedem Durchlauf stehen mehr Daten zur Verfügung, die einen gezielteren Vorgang beim nächsten Durchlauf ermöglichen. Am Ende des Prototyping liegen folgende Ergebnisse vor:

Bei der Operationalisation geht es um die Produktivstellung des Use Cases. Um gemeinsam mit Ihnen eine Priorisierung für den Rollout bezüglich der Komponenten Funktionen, Kunden und Märkte vorzunehmen, startet der dritte Schritt mit der Entwicklung eines Skalierungsplans, der Big-Data-geeignet ist. Das aus dem Piloten entwickelte Rollout erfolgt Schrittweise. Die Nutzerzahl wird kontinuierlich erhöht, um mehr Daten zur Optimierung des Prototyps zu generieren. Im Fokus der Optimierung stehen das technische (etwa Status oder Uptime) sowie das fachliche Monitoring (etwa Prognosegüte im Zeitverlauf). Auf diese Weise wird der Pilot sukzessive zu einem robusten Data-Science-Produkt entwickelt. Durch umfangreiches Testen in der Entwicklungsphase entsteht aus dem ausgearbeiteten Piloten ein marktfähiger Data Science Use Case.

Das Data-and-Analytics-Umfeld umfasst verschiedene statistische Methoden. Genauso vielfältig ist auch die Tätigkeit in diesem Umfeld.

Keine Webseite und keine Broschüre kann das persönliche Gespräch über Ihre Ziele und Ihre Themen ersetzen. Wir freuen uns auf einen Termin bei Ihnen vor Ort.

Senior Business Development Manager Robin Vorauer robin.vorauer@adesso.at