22. Mai 2025 von Paula Johanna Andreeva und Sarah Fürstenberg

Der EU-AI-Act: Was Unternehmen jetzt wissen und tun sollten

Was ist der EU-AI-Act?

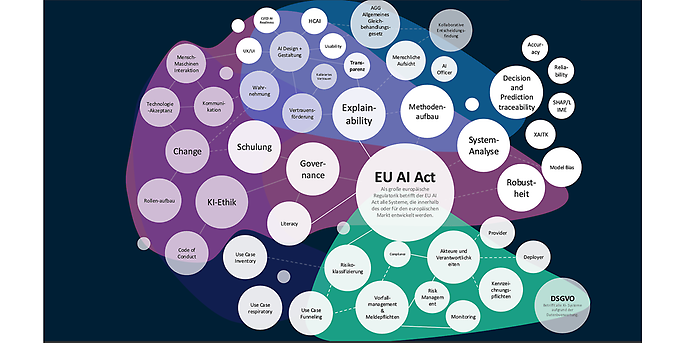

Der EU-AI-Act ist die erste umfassende Gesetzgebung weltweit, die Regeln für Künstliche Intelligenz (KI) mit konkreten Durchsetzungsmechanismen schafft. Ziel ist die Förderung von AI-Systemen, die Innovation mit Vertrauenswürdigkeit verbinden und dabei Grundrechte sowie europäische Werte respektieren. Über die definierten Verantwortungen hinaus bringt der Act deswegen weitaus mehr mit sich und kann als Sprungbrett benutzt werden, um Unternehmen zukunftssicher zu machen im Thema AI. Eine Darstellung der relevanten Themenbereiche findet ihr hier:

Der EU AI Act und Vertrauenswürdigkeit

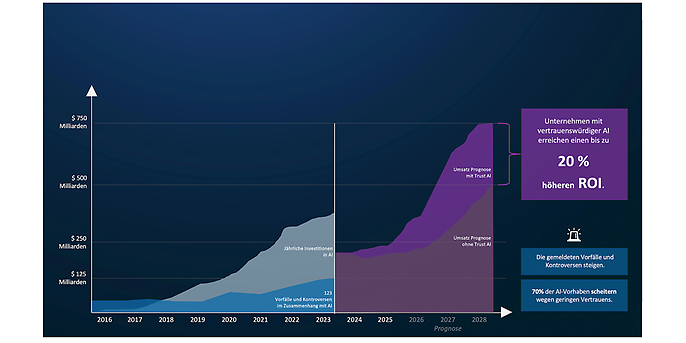

Der EU-AI-Act macht „Trust by Design“ quasi zur regulatorischen Pflicht. Vertrauenswürdige AI ist kein Zusatz, sondern Voraussetzung für nachhaltige Wertschöpfung. Trustworthy AI ist die verantwortungsvolle Entwicklung und Implementierung von AI-Technologien, die Transparenz, Fairness und Zuverlässigkeit priorisiert, um Akzeptanz im Einklang mit gesellschaftlichen Werten und gesetzlichen Standards zu fördern. Nach konservativen Schätzungen geht adesso davon aus, dass Unternehmen, die auf vertrauenswürdige KI setzen, einen bis zu 20 Prozent höheren ROI erzielen.

Jedes AI-Projekt ist auch ein Trust-AI-Projekt! Mögliches Potential durch Trustworthy AI

Grundlegende Bestandteile des EU-AI-Acts

Definitionen und Anwendungsbereich

Der EU-AI-Act definiert AI-Systeme als Software, die durch maschinelles Lernen, logikbasierte oder statistische Methoden Ergebnisse generiert und Entscheidungen beeinflusst. Er gilt für Anbieter, Nutzende, Vertreiber und Importeure - sofern AI-Systeme auf dem EU-Markt in Verkehr gebracht oder genutzt werden.

Akteure und Verantwortlichkeiten

Der EU-AI-Act unterscheidet verschiedene Akteursrollen:

- Anbieter (Provider): Entwickeln und vertreiben AI-Systeme. Sie tragen die Hauptverantwortung für Konformität.

- Nutzende (Deployers): Setzen AI professionell ein – zum Beispiel in den Bereichen HR, Justiz oder Medizin. Sie müssen über angemessene Kenntnisse verfügen und Systeme korrekt anwenden.

- Importeure und Händler: Müssen sicherstellen, dass nur konforme Produkte in Verkehr gebracht werden.

- Benannte Stellen und Behörden: Führen Prüfungen, Überwachungen und Sanktionen durch. In Deutschland übernehmen unter anderem die Bundesnetzagentur (Marktüberwachung), die Datenschutzkonferenz (Grundrechtsschutz) und die DAkkS (Zertifizierungsaufsicht) zentrale Aufgaben.

Risikoklassifizierungssystem

Der EU-AI-Act basiert auf einem risikobasierten Regulierungsansatz, bei dem AI-Systeme in vier Kategorien eingestuft werden: unannehmbar, hoch, begrenzt und minimal.

- Unannehmbares Risiko: Verbotene Systeme, etwa manipulative Technologien oder soziale Überwachung.

- Hohes Risiko: Beispielsweise AI in kritischer Infrastruktur, Bildung, Justiz. Hier gelten Anforderungen wie Risikomanagement, Transparenz und menschliche Kontrolle.

- Begrenztes Risiko: Zum Beispiel bei Chatbots.

- Minimales Risiko: Unter anderem Spamfilter, ohne regulative Eingriffe.

Systeme mit unannehmbarem Risiko, etwa manipulative Technologien oder soziale Überwachung, sind vollständig verboten. Hochrisikosysteme unterliegen strengen Anforderungen, die Risikobewertung, Datenqualitätsmanagement, menschliche Überwachung und Konformitätsbewertung umfassen.

Generative AI mit adesso

Von der Idee zur skalierbaren Lösung

Ob strategische Beratung, passgenaue Use Cases oder maßgeschneiderte Implementierung – adesso begleitet Unternehmen auf dem Weg zur erfolgreichen Nutzung von Generative AI. Mit fundierter Branchenexpertise, technologischer Exzellenz und einem klaren Fokus auf Business Value entwickeln wir KI-Lösungen, die echten Mehrwert schaffen.

To-Dos für Unternehmen

Um rechtzeitig compliant zu sein, raten wir Organisationen folgende Maßnahmen einzuleiten:

1. Inventarisieren: Überblick über eingesetzte AI-Systeme schaffen

- Ein AI Inventory ist eine zentrale Übersicht über alle AI-Systeme, die in einem Unternehmen genutzt werden. Es dokumentiert Einsatzbereiche, Datenquellen, Algorithmen und potenzielle Risiken. Ein Repository hingegen ist eine strukturierte Datenbank, die technische Details, Dokumentationen und Compliance-Nachweise zu diesen Systemen speichert. Beide Tools sind für den EU AI Act essenziell, da sie Transparenz schaffen, die Einhaltung gesetzlicher Vorgaben erleichtern und Unternehmen bei der Risikobewertung unterstützen. Dies ermöglicht eine effiziente Verwaltung und Nachverfolgung von AI-Systemen sowie eine proaktive Einhaltung der Vorschriften des EU AI Acts.

2. Klassifizieren: Risiken bewerten und Systeme zuordnen

- Die Nutzung von Modellen wie CapAI und dem NIST Risk Management Framework kann Unternehmen helfen, Risiken ganzheitlich zu bewerten und den finanziellen Mehrwert von AI-Use-Cases zu maximieren. CapAI wurde entwickelt, um die Konformität von AI-Systemen mit dem EU AI Act zu prüfen und liefert klare Leitlinien, um regulatorische, ethische und technische Risiken frühzeitig zu identifizieren. Dies unterstützt Unternehmen dabei, Strategien zu entwickeln, die nicht nur Risiken minimieren, sondern den Wert ihrer AI-Anwendungen steigern können. Das NIST Framework ergänzt diesen Ansatz, indem es technische und organisatorische Risiken entlang des gesamten AI-Lebenszyklus integriert. Es bietet einen strukturierten Rahmen, um Schwachstellen zu analysieren und gezielt zu managen, was die Effizienz von Investitionen in AI-Use-Cases steigert. Durch die Kombination beider Ansätze können Unternehmen fundierte Entscheidungen treffen, die sowohl die Compliance sicherstellen als auch den langfristigen finanziellen Nutzen ihrer AI-Systeme maximieren.

3. Dokumentieren: Technische Unterlagen und Risikoanalysen erstellen

- Eine effektive Dokumentation umfasst zunächst alle regulatorischen Anforderungen, wie die Erstellung technischer Dokumentationen, Risikobewertungen und die Sicherstellung der Nachvollziehbarkeit von Entscheidungen. Dies gewährleistet Compliance und minimiert rechtliche Risiken. Dazu gehört, die Kosten jedes Use-Cases zu analysieren - etwa durch die Bewertung von Effizienzgewinnen, Kosteneinsparungen oder Umsatzsteigerungen. Durch die Verknüpfung von Compliance-Anforderungen mit einer strategischen Nutzenanalyse können Unternehmen nicht nur regulatorische Risiken minimieren, sondern auch die Rentabilität ihrer AI-Investitionen langfristig sichern.

4. Governance stärken: Interne Zuständigkeiten und Prozesse definieren

- Die Klärung von Verantwortlichkeiten für AI-Systeme geht über die regulatorischen Anforderungen des EU AI Acts hinaus und ist entscheidend für die effiziente Umsetzung und den wirtschaftlichen Erfolg von AI-Initiativen. Klare Rollen fördern die Zusammenarbeit und minimieren Risiken, da Verantwortlichkeiten für Entwicklung, Einsatz und Monitoring eindeutig definiert sind. Das "Hub-and-Spoke" Modell ist dabei ein bewährter Ansatz: Ein zentraler "Hub" gibt Standards und Richtlinien vor, während dezentrale "Spokes" spezifische AI-Use-Cases umsetzen und anpassen. Dieses Modell fördert Flexibilität und Skalierbarkeit und unterstützt durch Change-Management den Umgang mit technologischen und organisatorischen Veränderungen. So wird nicht nur Compliance sichergestellt, sondern auch der langfristige geschäftliche Mehrwert maximiert.

- Eine zentrale Rolle nimmt die AI-Beauftragte Person ein: diese sorgt für die Einhaltung regulatorischer Pflichten, koordiniert Risikobewertungen, etabliert Governance-Strukturen und verankert ethische Prinzipien im AI-Lebenszyklus. Darüber hinaus kann diese Person die Kommunikation mit Stakeholdern unterstützen und die strategische Einbindung von AI-Anwendungen vorantreiben. Ergänzend kann ein AI-Ethikbeirat als beratendes Gremium dienen, das für zusätzliche Transparenz und Aufsicht sorgt.

5. Schulungen anbieten: Fachbereiche und Management sensibilisieren

- AI-Schulungen sind weit mehr als nur eine Maßnahme zur Einhaltung des EU AI Acts. Sie ermöglichen es, Mitarbeitenden Ängste im Umgang mit AI abzubauen und das Potenzial der Technologie zu erkennen. Besonders wichtig ist, dass solche Schulungen Mitarbeitende befähigen, selbstständig innovative AI-Use-Cases zu entwickeln. Das fördert eine Kultur der Eigeninitiative und eröffnet neue Geschäftschancen. Gleichzeitig wird durch ein besseres Verständnis der Technologie sichergestellt, dass AI-Systeme sicher und effizient genutzt werden, was langfristig den Erfolg des Unternehmens steigert.

6. Sandbox nutzen: Neue Systeme unter Aufsicht testen

- Entwicklungs-Sandboxes und AI Regulatory Sandboxes haben unterschiedliche Zwecke und Zielgruppen, sind jedoch beide essenziell für sichere und innovative AI-Entwicklung.

- Coding Sandboxes bieten Entwicklerinnen und Entwicklern isolierte Umgebungen, um Code risikofrei zu testen und technische Fehler frühzeitig zu erkennen. Sie fördern Kreativität und technische Innovation, ohne bestehende Systeme zu gefährden.

- AI Regulatory Sandboxes hingegen sind von den EU-Mitgliedstaaten vorgeschriebene, regulierte Umgebungen, in denen AI-Systeme unter Aufsicht getestet werden, um ihre Konformität mit dem EU AI Act sicherzustellen. Diese Sandboxes zielen darauf ab, Risiken für Grundrechte, Gesundheit und Sicherheit zu minimieren und gleichzeitig Innovationen zu fördern

Bereit für die nächsten Schritte?

Der EU-AI-Act stellt viele Unternehmen vor neue Herausforderungen – aber auch vor große Chancen. adesso unterstützt euch dabei, diese Potenziale sicher und strategisch zu nutzen. Lasst uns gemeinsam sicherstellen, dass eure KI-Initiativen nicht nur gesetzeskonform, sondern auch zukunftsweisend sind.

Fristen und Deadlines

Die Umsetzung erfolgt in Etappen:

- Seit 2. Februar 2025: Verbot von AI-Systemen mit unannehmbarem Risiko.

- 2025–2026: Schrittweises Inkrafttreten der Vorschriften zu GPAI, Hochrisiko-Systemen, Governance und Transparenz.

- Bis Anfang 2026: Unternehmen müssen Schulungen, Risikoanalysen und Dokumentationspflichten umgesetzt haben.

Die Fristen variieren je nach Risikoklasse und Rolle, frühzeitige Vorbereitung ist entscheidend, um Umsetzungsdruck und Bußgelder zu vermeiden.

Fazit: Jetzt vorbereitet handeln

Der EU-AI-Act ist mehr als nur Regulierung, er ist ein Signal für verantwortungsvolle Innovation. Unternehmen, die jetzt handeln, sichern nicht nur Compliance, sondern schaffen Vertrauen und strategischen Mehrwert. Wir unterstützen euch gern, von der Gap-Analyse über Schulungskonzepte bis zur Auditvorbereitung.