23. September 2022 von Marc Mezger

Explainable AI – Eine kurze Einführung

Was ist Explainable AI?

Künstliche Intelligenz (KI) ist in unserer Gesellschaft mit Tools wie Siri und Alexa endgültig angekommen und wird von vielen Menschen verwendet, ohne dass sie es überhaupt merken. Um zu beurteilen, ob diese Systeme fair und ohne Bias und Diskriminierung agieren, müssen wir sie erst einmal verstehen können. Dieses Verständnis versucht man durch Explainable AI zu erreichen. Das Forschungsfeld Explainable AI (XAI) beschäftigt sich mit der Interpretierbarkeit von Maschine- und Deep-Learning-Verfahren. Die Notwendigkeit für eine solche Forschung gibt es bereits seit den frühen Tagen von Expertensystemen und wird heute mit der Komplexität von neuronalen Netzen anspruchsvoller und gleichzeitig viel wichtiger, da diese viel komplexere Aufgaben und Abstraktionen ermöglichen. Google selbst erwähnt in seinem Whitepaper zu KI folgende Argumentation: „The Primary function of explanations is to facilitate learning better mental models for how events come about“. Das heißt, der Hauptfokus von Erklärungen darin besteht, dass Menschen ihre mentale Repräsentation und ihr Verständnis verbessern können. Dies bezieht sich vor allem auch darauf, dass beim menschlichen Lernprozess das Verständnis iterativ verbessert wird. Im Whitepaper heißt es weiter: „People then use these mental models for prediction and control. It’s natural then to expect people to ask for explanations when faced with abnormal or unexpected events, which essentially violate their existing mental model and are therefore surprising from their point of view.“

Zusammenfassend gibt es fünf Gründe, warum Erklärungen von Machine- oder Deep-Learning-Modellen notwendig sind:

- Unterstützung für die menschliche Entscheidungsfindung: Darunter ist zu verstehen, dass es Möglichkeiten gibt, die Entscheidungen der KI für einen Menschen verständlich zu erklären, und vor allem zu verstehen, welche Kombination von Input-Parametern zu einer Entscheidung führt. Je komplizierter und je größer die Modelle sind, desto aufwendiger ist dies. Als Beispiel hierfür dient, dass eine Ärztin oder Arzt verstehen muss, warum die KI eine Therapie vorschlägt, um gegenüber einer Patientin oder einem Patienten eine Erklärung für eine geplante Behandlung zu haben.

- Verbesserte Transparenz: Durch Transparenz kann der User Vertrauen zum System aufbauen. Denn wenn dieser in der Lage ist zu verstehen, wie das Modell agiert beziehungsweise wie es zu einer Entscheidung kommt, resultiert daraus ein gemeinsames Verständnis zwischen KI und Mensch. Dieses gleiche Verständnis führt zu Akzeptanz und Vertrauen beim Menschen.

- Debugging: Die Möglichkeit, ein System zu debuggen, zum Beispiel wenn Fehler auftreten oder das KI-Modell sich unvorhergesehen verhält. Wenn zum Beispiel Kredite für junge Personen mit gutem Gehalt abgelehnt werden und es wichtig ist zu verstehen, warum das so ist, um das Modell zu optimieren.

- Auditing: Hierbei geht es um die Möglichkeit, für zukünftige regulatorische Anforderungen gewappnet zu sein. Hierbei ist insbesondere der zukünftige AI Act relevant. Mehr dazu erfahrt ihr übrigens in diesem Blog-Beitrag. Es ist wichtig, dass ein Modell verstanden wird, um seine Sicherheit bewerten zu können.

- Verifikation von Generalisierbarkeit und Vertrauen: Für KI-Modelle ist es immer wichtig zu erkennen, ob sie in der Lage sind zu generalisieren. Nur wenn das der Fall ist, kann das Vertrauen in das System wachsen. Dies gehört zu einem wichtigen Forschungsfeld namens Trustworthy AI, das bereits in dem genannten Blog-Beitrag näher erklärt wurde.

Der Bezug zu Trustworthy AI

Zum Thema Trustworthy AI ist bereits der oben genannte Blog-Beitrag meiner Kollegin und adesso-Expertin Lilian Do Khac erschienen; da dies aber für das Verständnis von Explainable AI sehr wichtig ist, werde ich eine Zusammenfassung geben: Bei Trustworthy AI handelt es sich um ein Framework, das die Ziele Human Oversight, Technical Robustness, Privacy & Data Governance, Transparency, Fairness, Social und/oder Environmental Wellbeing sowie Accountability als essenziell bewertet, um Vertrauen in ein KI-System aufzubauen. Ohne das notwendige Vertrauen wird die KI auf lange Sicht immer abgelehnt, wodurch der Einsatz in der Praxis problematisch und in Zukunft zu regulatorischen Problemen führen wird.

Der Nutzen von Explainable AI (Quelle: https://www.darpa.mil/program/explainable-artificial-intelligence)

Die obere Abbildung zeigt, wie der aktuelle Prozess ohne Explainable AI strukturiert ist. Dabei wird ein Machine-Learning-Algorithmus, der auf Trainingsdaten basiert, trainiert. Das Ziel: Daten von verschiedenen Klassen zu trennen oder numerische Werte vorherzusagen. Diese gelernte Entscheidungslogik wird verwendet, um bei neuen Daten eine Entscheidung für die Vorhersage zu treffen. Die Vorhersage wird dem User übermittelt – allerdings ohne eine Begründung, warum es zu dieser Entscheidung kam. Der User stellt sich daher folgende Fragen: Warum wurde diese Entscheidung gefällt? Und wie kann man dem Model vertrauen, wenn man nicht weiß, wie die Entscheidung zustande gekommen ist?

Mit Explainable AI gibt es zusätzlich zum gelernten Modell ein Erklärungsmodell mit einem Interface für den User, sodass dieser in der Lage ist zu verstehen, warum ein Model eine Entscheidung getroffen hat. Dies führt zu einem gewissen Vertrauen, da der Entscheidungsprozess transparent gemacht wird.

Warum ist Explainable AI wirklich notwendig und nicht nur für die Forschung interessant?

Im Grunde genommen gibt es drei standardisierte Anwendungsfälle, um zu zeigen, warum Explainable AI essenziell ist und dieses Thema nicht vernachlässigt werden darf:

- Der erste Anwendungsfall ist die Verwendung von KI zur Erkennung von Krankheiten im medizinischen Kontext. Ein Beispiel hierfür ist eine KI, die automatisiert Computertomographen-Bilder auf die Existenz oder Nichtexistenz von Krebszellen durchsucht. Da eine KI eine Entscheidung darüber fällt, welche Bilder die Ärztin oder der Arzt genauer untersuchen soll, muss erklärbar sein, wie die KI zu ihrer Entscheidung kommt. Zum einen, weil Ärztinnen und Ärzte generell niemals einem System vertrauen, das die Entscheidung nicht nachvollziehbar erklären kann. Zum anderen, weil ein derartiges System darauf optimiert sein muss, möglichst alle Verdachtsfälle bei Patientinnen und Patienten zu finden. Zeitgleich muss die KI aber möglichst wenig falsche Bilder senden, um das ärztliche Personal nicht zu überlasten, damit daraus keine Fehler resultieren.

- Der zweite Anwendungsfall bezieht sich auf das Credit Scoring und allgemein auf das Thema Liquiditätsvorhersagen. Hierbei sagt eine KI das Risiko voraus, ob eine Person mit gewissen Eigenschaften (unter anderem Job, Gehalt oder Alter) in der Lage sein wird, einen Kredit in einer gewissen Höhe bedienen kann oder nicht. Hierbei ist Explainability wichtig, um zu verhindern, dass nicht gegen § 1 und 2 des Allgemeinen Gleichbehandlungsgesetzes verstoßen wird – also keine Diskriminierung vorliegt. Zudem ist es auch wichtig zu verstehen, wie eine Entscheidung getroffen wird, um zu verhindern, dass bestimmte Personen, die ein bestimmtes Merkmal aufweisen – etwa ein hohes Alter –, nicht diskriminiert oder benachteiligt werden.

- Der dritte Anwendungsfall ist Predictive Policing. Dabei handelt es sich um einen KI-getriebenen Ansatz zur Vorhersage von Verbrechen. Diesen kann die Polizei nutzen, um Hotspots für Verbrechen zu erkennen und/oder um für bestimmte Personen die Wahrscheinlichkeit, ein Verbrechen zu begehen, vorherzusagen. Eine Firma, die sich auf diesen Prozess spezialisiert hat, ist Palantir. Sie hat unter anderem Kooperationen mit der Polizei in Nordrhein-Westfalen und Bayern. Eine Software, die so etwas kann, wird also bereits in Deutschland eingesetzt. Da die Modelle hinter den Vorhersagen oft aus den USA kommen und es dort schwere Probleme mit Racial Profiling und Diskriminierung gibt, ist es hier besonders wichtig zu verstehen, warum Modelle eine Vorhersage treffen.

Es gibt eine Vielzahl von weiteren Beispielen, warum Explainable AI so wichtig für den Einsatz von Machine- und Deep-Learning-Algorithmen in der Praxis ist. Leider würde eine ausführliche Beschreibung den Rahmen dieses Beitrag sprengen.

Die Funktionsweise von Explainable AI

Investigation of Black Box Model

Normalerweise ist es so, dass die meisten verwendeten Machine- und Deep-Learning-Verfahren sogenannte Black Box Models sind. Das bedeutet, es ist unklar, was im Inneren genau passiert, und deshalb ist es schwierig, die Entscheidung nachzuvollziehen. Beispiele für Black-Box-Modelle sind zum einen neuronale Netzwerke (Deep Learning), Support-Vektor-Maschinen (SVMs) und Ensemble-Klassifikatoren. Selbstverständlich gibt es auch das Gegenteil, die sogenannten White-Box-Modelle. Bei diesen Modellen ist es einfacher, die Entscheidungen zu verstehen, da sie auf einfacheren Verfahren beruhen beziehungsweise viel weniger Parameter besitzen. Beispiele für White-Box-Modelle sind unter anderem regelbasierte Klassifikatoren und Entscheidungsbäume.

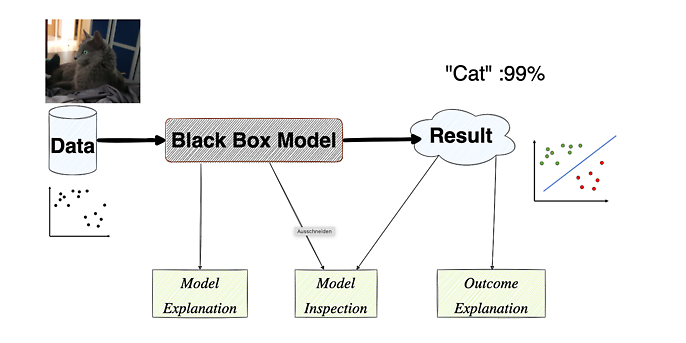

In der zweiten Abbildung ist die typische Struktur einer Machine-Learning-Anwendung zu sehen. Links haben wir Daten wie zum Beispiel Bilder, numerische oder andere Arten von Daten. Diese gehen durch ein Modell, hier als Black Box Model bezeichnet, da nicht klar ist, was im Inneren passiert. Danach wird ein Ergebnis ausgegeben, wie zum Beispiel, dass es sich bei dem Bild mit einer Wahrscheinlichkeit von 99 Prozent um eine Katze handelt oder eine Vorhersage für eine Trennlinie für numerische Daten. Es gibt drei Arten, um Explainable AI in so einem Konstrukt anzuwenden:

Model Explanation: Hier geht es darum, das Modell zu erklären und nicht nur eine einzelne Entscheidung des Modells. Eine Möglichkeit, dies zu erreichen, besteht darin, ein interpretierbares Machine-Learning-Modell zu verwenden, das mit dem Input der Testvariablen auf den Output der Black Box trainiert wird. Dadurch kann man die Black Box simulieren und durch das Verwenden eines White-Box-Modells die Ergebnisse verstehen und erklärbar machen. Model Explanation beschäftigt sich mit dem Modell sowie den Ergebnissen, die vom Black Box Model erstellt werden.

Model Inspection: Hier geht es darum, eine Repräsentation zu erstellen, um die Eigenschaften des Black-Box-Modells oder der Vorhersagen zu erklären. Dies kann zum Beispiel dadurch geschehen, dass man den Output von Testinstanzen dazu benutzt, eine Graphik zu erzeugen. Zum Beispiel wäre die Sensitivität für Variablenwechsel eine Möglichkeit, um die Repräsentation des Modells als Graph darzustellen.

Outcome Explanation: Bei diesem Verfahren geht es darum, dass eine Erklärung für einen einzelnen Input gegeben werden muss. Es geht also nicht darum, das gesamte Modell zu verstehen, sondern nur eine Begründung für eine Entscheidung. Als Beispiel könnte man hier einen Entscheidungsbaum nehmen, dessen relevanter Pfad abgeschritten und als Erklärung verwendet wird.

Generell ist es so, dass für Machine-Learning-Verfahren Explainable AI relativ einfach durchzuführen ist, da es sich um eine relativ geringe Anzahl an Komponenten handelt, die eine Entscheidung treffen. Bei Deep Learning und den dabei verwendeten neuronalen Netzen ist dies viel schwerer, da die Anzahl der Komponenten hier leicht in die Tausenden oder Millionen gehen. Eines der verbreitetsten Netzwerke für Natural Language Processing (Sprachverarbeitung) – GPT-3 – hat eine Anzahl von 175 Milliarden Parametern – dies macht Explainable AI deutlich schwieriger, aber nicht unmöglich.

Beispiele für Explainable AI

Ich möchte euch ein paar Beispiele vorstellen, wie Explainable AI aussehen kann und wie man sie verwenden kann, um Entscheidungen zu erklären oder nachzuvollziehen. Es erfolgt kein detailliertes standardisiertes Vorgehen, wie wir es selbst für unsere Anwendungen praktizieren, es soll aber einen kurzen Einblick in einfache Möglichkeiten geben. Genauer möchte ich diese Verfahren mit Beispielen in einem weiteren Blog-Artikel zeigen.

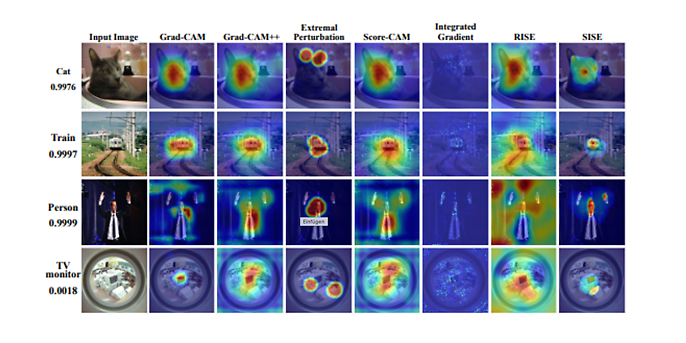

Heatmap-Methoden für Convolutional Neuronal Networks, Quelle: https://arxiv.org/pdf/2010.00672.pdf

In der oberen Abbildung ist links das Input-Bild zu sehen, das einem Convolutional Neural Network (einem Netzwerk für Bilderkennung) übergehen wird, rechts daneben sind Heatmaps zu sehen. Diese zeigen die Teile des Bildes, die am wichtigsten für die Entscheidungen des Netzwerks sind. Je roter der Bereich ist, desto wichtiger ist er. An diesem Beispiel ist recht gut erkennbar, dass sich das Netzwerk für eine Katze sowie für einen Menschen oft auf das Gesicht konzentriert.

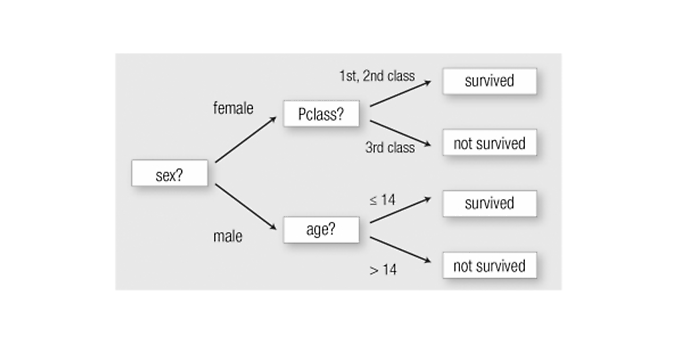

In der folgenden Abbildung ist die Entscheidung eines Entscheidungsbaums aufgezeigt. Darin wird beispielhaft die Erklärung für die Entscheidung für die Überlebensvorhersage bei Titanic-Passagieren gezeigt. Anhand von verschiedenen Variablen, die abgefragt werden, können Entscheidungen getroffen werden

Erklärung für die Entscheidung für die Überlebensvorhersage bei Titanic-Passagieren. (Quelle: https://dl.acm.org/doi/fullHtml/10.1145/3236009)

Mit diesen beiden Beispielen möchte ich meine kurze Exkursion in die Welt der Explainable AI abschließen. In einem weiteren Blog-Beitrag werde ich andere Techniken, vor allem für Computer Vision und Natural Language Processing, vorstellen. Es bleibt also spannend.

Weitere spannende Themen aus der adesso-Welt findet ihr in unseren bisher erschienen Blog-Beiträgen.