10. Juli 2023 von Marc Mezger

Quickstart mit einem europäischen Large Language Model: Aleph Alpha’s Luminous

Aleph Alpha ist ein Heidelberger KI-Unternehmen, das sich zum Ziel gesetzt hat, eine europäische Alternative zu OpenAI zu schaffen. Der Gründer Jonas Andrulis war als Teamleiter in der KI-Forschung bei Apple tätig, als er die faszinierenden Entwicklungen auf dem Gebiet der Artificial General Intelligence (AGI) bemerkte. Andrulis stellte zu seinem Erstaunen fest, dass sich in Europa niemand darangemacht hatte, ein AGI-Modell zu entwickeln. Er beschloss, tätig zu werden, kündigte seine Stelle bei Apple und gründete 2019 Aleph Alpha.

Aleph Alpha arbeitet an der technischen Entwicklung von Large Language Models (LLMs) in Kooperation mit führenden europäischen Universitäten und Forschungseinrichtungen.

Das Unternehmen will Modelle entwickeln, die sicher, transparent und fair gestaltet sind und in Übereinstimmung mit unseren gesellschaftlichen Werten stehen. Die Entwicklung von Aleph Alpha läuft zweigleisig:

- Das Unternehmen intensiviert die technische Entwicklung der LLMs, um eine tragfähige Basis für die späteren Anwendungen zu schaffen.

- Jonas Andrulis sucht engagierte Kooperationspartnerschaften, um gemeinsam inspirierende Lösungen zu finden.

Die LLMs sind ausgesprochen rechenintensiv. Dies macht den Aufbau wettbewerbsfähiger Rechenkapazitäten und die Sorge für deren nachhaltigen Ausbau zur obersten Priorität. Andrulis hat sich ganz bewusst dafür entschieden, alle Mitarbeiterinnen und Mitarbeiter zum Umzug nach Heidelberg zu bewegen, um den persönlichen Austausch vor Ort zu stärken und das angenehme Arbeitsklima zu fördern. Heidelberg bietet Aleph Alpha als Standort eine enorme Dichte an phänomenalen Hochschulen und engagierten Technikerinnen und Technikern sowie Ingenieurinnen und Ingenieuren in den Unternehmen der Region. Einen zusätzlichen Standort hat Aleph Alpha in Berlin.

Warum ist europäische KI so wichtig?

In der heutigen digitalen Welt ist künstliche Intelligenz (KI) ein entscheidender Faktor für technologischen Fortschritt, Wirtschaftswachstum und Wettbewerbsfähigkeit. Die Entwicklung einer starken europäischen KI ist für Europa von immenser Bedeutung, insbesondere im Zusammenhang mit dem US-amerikanischen Cloud Act (Clarifying Lawful Overseas Use of Data Act) von 2018, der weitreichende Auswirkungen auf Datenschutz und Datensouveränität hat. In diesem formellen Text werden wir die Gründe für die Wichtigkeit der europäischen KI für Europa erläutern.

Datenschutz und Datensouveränität

Der Cloud Act ermöglicht es US-Behörden, auf in Cloud-Diensten gespeicherte Daten zuzugreifen, unabhängig vom Speicherort der Daten und ohne Rücksicht auf lokale Datenschutzgesetze. Dies stellt eine erhebliche Herausforderung für den Schutz der Privatsphäre von europäischen Bürgerinnen und Bürgern sowie Unternehmen dar. Die Entwicklung eigener europäischer KI-Technologien und -Infrastrukturen kann dazu beitragen, die Abhängigkeit von amerikanischen Cloud-Diensten zu verringern und die Kontrolle über europäische Daten in europäischen Händen zu halten.

Wettbewerbsfähigkeit und Innovation

Europa muss in den globalen KI-Markt investieren, um wettbewerbsfähig zu bleiben und Innovationen voranzutreiben. Durch die Schaffung eigener KI-Technologien kann Europa seine Position im internationalen Wettbewerb stärken und dazu beitragen, dass europäische Unternehmen in der Lage sind, mit globalen Technologiegiganten wie den USA und China Schritt zu halten.

Einhaltung europäischer Werte und Regulierungen

Indem Europa seine eigene KI entwickelt, kann sichergestellt werden, dass diese Technologien den europäischen Werten und Gesetzen entsprechen, wie beispielsweise der Datenschutz-Grundverordnung (DSGVO). Somit wird gewährleistet, dass die Privatsphäre und die Grundrechte der europäischen Bürgerinnen und Bürger geschützt sind, während gleichzeitig Innovation und technologischer Fortschritt gefördert werden.

Quickest Quickstart Possible

Aleph Alpha bietet die Möglichkeit, die Modelle kostenlos auszuprobieren, indem einige Tokens zur Verfügung gestellt werden. Um von dieser Möglichkeit Gebrauch zu machen, kann man sich auf der Website https://app.aleph-alpha.com/ registrieren. Nach der Anmeldung kann man in der linken oberen Ecke des Bildschirms auf „Playground“ klicken und im Drop-down-Menü „Get Started“ auswählen. Dort stehen zahlreiche Beispiele zur Verfügung, die man sofort ausprobieren kann. Für weitere Möglichkeiten kann man auf „Playground -> Complete“ klicken.

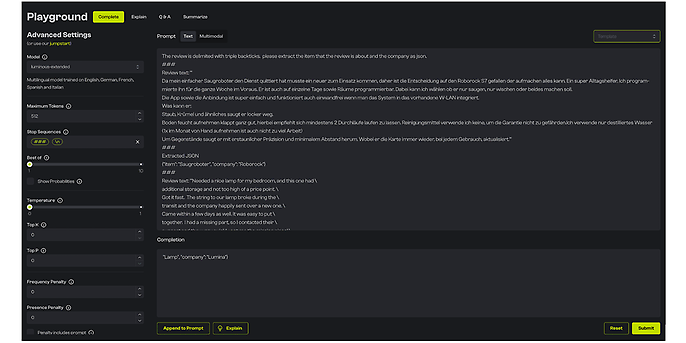

Die Oberfläche des Playgrounds, Quelle: Aleph Alpha

Zunächst mag die Benutzeroberfläche etwas komplex erscheinen, jedoch ist ihre Bedienung schnell erklärt. Auf der linken Seite der Oberfläche finden sich die Einstellungen, mit denen man spezifische Eigenschaften des Modells verändern kann. Unter dem Punkt „Model“ kann man zwischen den vier Modellen Base, Extended, Supreme und Supreme-Control auswählen. Mit „Maximum Token“ wird die maximale Anzahl an Tokens (also Zeichen) angegeben, die das Modell ausgeben darf. Unter „Temperature“ kann man festlegen, wie kreativ das Modell antwortet. Ein höherer Wert führt zu unterschiedlicheren Antworten. Alle Einstellungen werden auch durch Klicken auf das „i“ erläutert.

Der große Kasten in der Mitte des Bildschirms ist der Eingabebereich für das Modell. Hier könnt ihr alles eingeben, was ihr dem Modell mitteilen möchtet. Dies können beispielsweise Texte sein, die zusammengefasst werden sollen, Dokumente, die ausgewertet werden sollen, Bilder oder einfach Fragen, auf die ihr eine Antwort sucht. Das Modell nutzt diese Eingabe, um auf Basis der vorhandenen Daten eine passende Antwort oder Auswertung zu generieren.

Sobald ihr eure Eingabe in den großen Kasten eingegeben habt, könnt ihr diese senden. Das Modell wird dann eure Anfrage bearbeiten und euch eine Antwort im unteren Kasten, dem sogenannten Completion-Feld, anzeigen.

Das rechte obere Drop-down-Menü bietet eine Auswahl an Anwendungsfällen, die als Beispiel dienen und die ihr ausprobieren könnt. Diese Anwendungsfälle demonstrieren, wie das Modell genutzt werden und welche Ergebnisse es erzielen kann. Ihr könnt diese Beispiele nutzen, um euch mit der Funktionsweise des Modells vertraut zu machen und zu experimentieren.

Modelle

Bei Aleph Alpha stehen drei grundlegende Modelle zur Verfügung, die zusätzlich in weiteren spezialisierten Konfigurationen erhältlich sind. Die Basis-Modelle umfassen Luminous-Base, Luminous-Extended und Luminous-Supreme. Zukünftig werden möglicherweise weitere Modelle hinzugefügt. Die Hauptunterschiede zwischen den Modellen liegen in ihrer Größe.

- Luminous-Base weist eine Größe von 13 Milliarden Parametern auf und gilt damit als kleineres Modell. Die Spezialmodelle für Base verfügen über die Fähigkeit, Bilder zu verarbeiten und Embeddings zu generieren. Mithilfe von Embeddings lässt sich die Semantik – also das zugrundeliegende Konzept eines Satzes – erfassen, wodurch KI-gestützte Dokumentendurchsuchungen ermöglicht werden und herausragende Ergebnisse erzielt werden können.

- Luminous-Extended ist mit 30 Milliarden Parametern deutlich größer und fungiert als das vielseitige „Schweizer Taschenmesser“ unter den Aleph-Alpha-Modellen. Es bietet bereits ausgezeichnete Leistung für die meisten Anwendungen und bleibt dabei mit ca. 0,4 ct pro DIN-A4-Seite sehr kosteneffizient.

- Luminous-Supreme ist mit 70 Milliarden Parametern das derzeit größte Modell. Ein Spezialmodell von Supreme ist Supreme-Control, das als steuerbares Modell bezeichnet wird. Dies bedeutet, dass man dem Modell eine bestimmte Rolle zuweisen kann, an der es sich orientiert. Beispielsweise könnte man das Modell anweisen, als ein Chatbot zu agieren, der stets in Gedichtform antwortet, woraufhin das Modell genau dies umsetzt.

Bei der Nutzung dieser Modelle ist es empfehlenswert, zunächst mit Luminous-Extended zu beginnen und anschließend iterativ zu testen, welches Modell den optimalen Kompromiss zwischen Kosten und Leistung bietet.

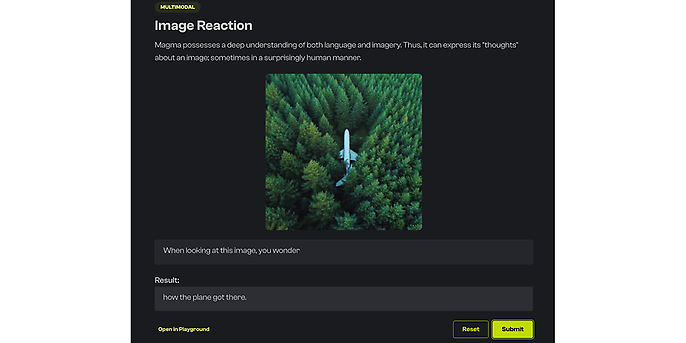

Zusätzlich gibt es noch Magma, einen Adapter. Damit habt ihr eine Möglichkeit, Bilder den Netzwerken zu übergeben und auswerten zu lassen.

Bilderauswertung, Quelle: Aleph Alpha

Explain

Explain ist eine neue Funktion von Aleph Alpha, die darauf abzielt, das Problem der Halluzinationen von LLMs zu lösen. LLMs neigen nämlich dazu, Informationen zu erfinden oder zu lügen, wenn sie nicht genau wissen, wie sie auf eine Anfrage antworten sollen. Dies kann zu ungenauen oder sogar falschen Antworten führen, was ein großes Problem beim Einsatz von LLMs in verschiedenen Anwendungsbereichen darstellt.

Explain bietet eine Lösung für dieses Problem, indem es der Userin oder dem User die Möglichkeit gibt, zu erkennen, ob die vom LLM generierte Information aus dem Text stammt oder nicht. Wenn eine Information nicht aus dem Text stammt, kann ein User oder eine Userin das Modell korrigieren und so sicherstellen, dass die generierte Antwort genau und präzise ist.

Um Explain auszuprobieren, müsst ihr im Complete-Modus eine Anfrage ausführen und dann auf den Explain-Button links unten auf dem Bildschirm klicken. Dadurch wird das Modell angewiesen, die generierte Information zu erklären, und es wird euch gezeigt, woher die Information stammt und wie sie generiert wurde. Auf diese Weise könnt ihr sicherstellen, dass die vom Modell generierte Information korrekt und vertrauenswürdig ist.

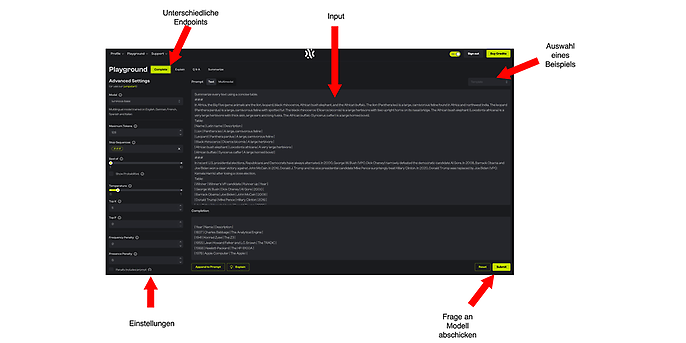

Funktionalität der Explain-Funktion, Quelle: Aleph Alpha

Der oben gezeigte Screenshot zeigt die Funktionalität der Explain-Funktion von Aleph Alpha. Die hervorgehobene Farbe des Textes gibt an, wie wichtig er für die Antwort ist: Je roter der Text markiert ist, desto wichtiger ist er für die generierte Antwort. Die Explain-Funktion ermöglicht es somit, zu erkennen, ob die Informationen im Output des Modells tatsächlich aus dem Text stammen, der dem Modell gegeben wurde, oder ob sie möglicherweise erfunden sind.

Durch die Verwendung der Explain-Funktion könnt ihr sicherstellen, dass die generierten Antworten auf einer genauen und vertrauenswürdigen Grundlage beruhen. Insbesondere ermöglicht es die Funktion, den sogenannten Halluzinationen von Large Language Models vorzubeugen, bei denen das Modell Informationen erfindet oder lügt, wenn es nicht genau weiß, wie es auf eine Anfrage antworten soll.

Insgesamt bietet die Explain-Funktion eine wichtige Möglichkeit, die Genauigkeit und Vertrauenswürdigkeit von Large Language Models zu verbessern und so ihre Anwendungsbereiche zu erweitern.

Prompts

Ein Prompt ist eine Eingabeaufforderung oder ein Anstoß, der an ein KI-Modell gesendet wird, um eine bestimmte Art von Antwort oder Reaktion zu erhalten. Prompts können in Form von Text, Bildern oder anderen Datenformaten präsentiert werden. Zum Beispiel kann ein Text-Prompt – Beispiel: „Übersetze den folgenden Text: ‚Hello, how are you?‘ ins Deutsche“ – verwendet werden, um von einem KI-Modell eine Übersetzung in deutscher Sprache zu erhalten.

Zero-Shot-Lernen bezieht sich auf die Fähigkeit eines KI-Modells, Aufgaben zu bewältigen, für die es während des Trainings keine expliziten Beispiele erhalten hat. Das Modell nutzt dabei sein allgemeines Wissen und seine Fähigkeit, Zusammenhänge herzustellen, um die Aufgabe zu lösen. Zum Beispiel kann ein KI-Modell, das für maschinelles Übersetzen trainiert wurde, gebeten werden, eine Textaufgabe in Mathematik zu lösen, ohne zuvor explizite Beispiele für solche Aufgaben gesehen zu haben.

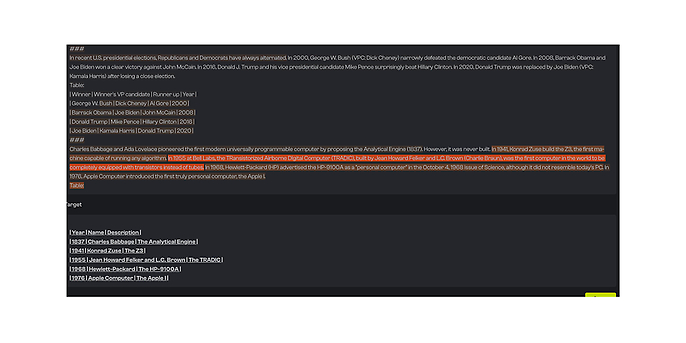

Few-Shot-Lernen ist der Prozess, bei dem ein KI-Modell eine neue Aufgabe mit nur wenigen Beispielen lernt. Im Gegensatz zum Zero-Shot-Lernen erhält das Modell hier einige exemplarische Datenpunkte, um seine Leistung bei der Lösung der neuen Aufgabe zu verbessern. Ein Beispiel dafür wäre, ein KI-Modell, das auf Englisch trainiert wurde, mit nur wenigen zusätzlichen Beispielen in einer neuen Sprache, wie etwa Französisch, zu trainieren und dann zu testen, wie gut es Texte in dieser Sprache übersetzt.

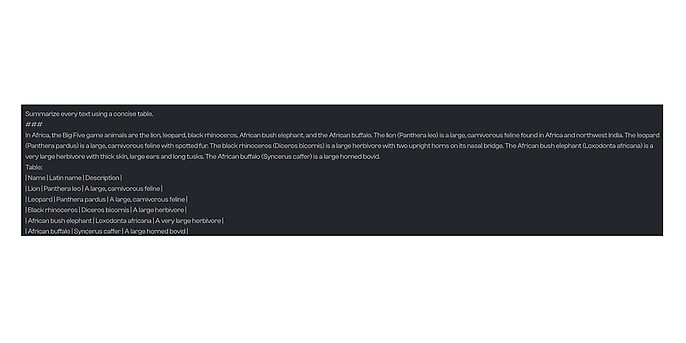

Ein Beispiel für einen Few Shot, Quelle: Aleph Alpha

API und Clients

Von Aleph Alpha gibt es zwei Clients und die normale REST-API. Die Clients sind in Python und Rust geschrieben und bieten die beste Möglichkeit, Modelle anzubinden. Natürlich kann dies auch alles über die REST-API gemacht werden, also über eigentlich jede Programmiersprache angesprochen werden. Die API-Dokumentation ist hier zu erreichen: https://docs.aleph-alpha.com/api/

Demo-Repository

Ich habe ein kleines Demo-Repository erstellt, das es ermöglicht, die API schnell und einfach mit Python zu nutzen. Zusätzlich bietet Aleph Alpha ein Demo-Repository an, mit dem die API direkt im Browser mithilfe von Google Colab ausprobiert werden kann. Mein Demo-Repository ist unter folgendem Link zu finden: https://github.com/mfmezger/aleph_alpha_quickstart (Python muss installiert sein)

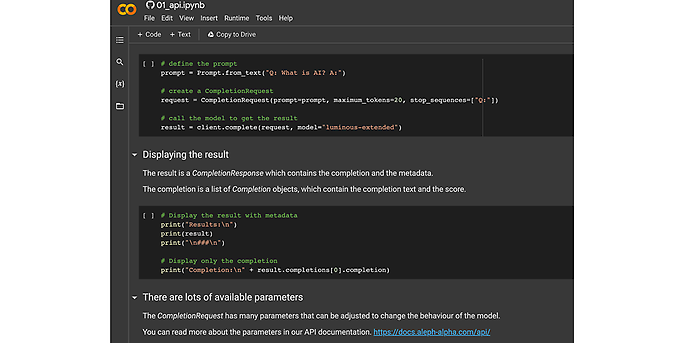

Das Online-Repository von Aleph Alpha befindet sich unter https://github.com/Aleph-Alpha/examples. Nach dem Öffnen der Seite kann man zum Kapitel „Overview“ scrollen und auf „Open in Colab“ klicken. Dadurch öffnet sich Google Colab (ein Google-Account ist erforderlich). Die einzelnen Zellen können durch Drücken von „Shift + Enter“ ausgeführt werden.

Google-Colab-Einführung in Aleph Alpha API, Quelle: Aleph Alpha

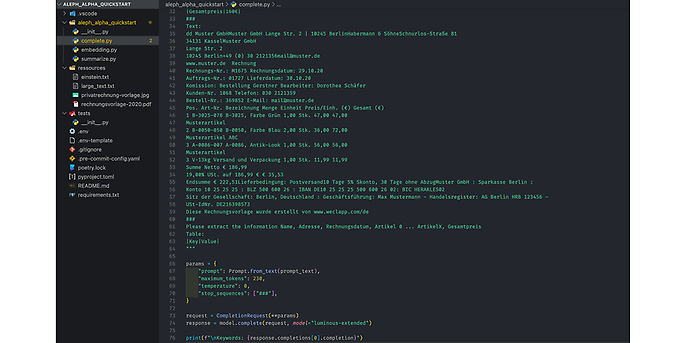

Eine kurze Einführung in mein Repository: Im Ordner „aleph_alpha_quickstart“ befinden sich drei Skripte, mit denen man die Fähigkeiten von Aleph Alpha testen kann. Das erste Skript heißt Complete. Es zeigt ein Beispiel, wie man aus Dokumenten Tabellen extrahieren kann. Im Embedding-Skript wird gezeigt, wie man mit Embeddings große Texte durchsuchbar machen kann. Das Summarize-Skript zeigt, wie man mit der API große Texte schnell zusammenfassen kann.

Complete.py, Quelle: Aleph Alpha

Ausblick

Ich hoffe, dass das Experimentieren mit dieser beeindruckenden Technologie für euch interessant und spannend ist. Solltet ihr Anwendungsfälle für Aleph Alpha bei euch oder euren Kundinnen und Kunden entdecken, zögert bitte nicht, adesso zu kontaktieren. Wir unterstützen euch gerne bei der schnellen Umsetzung von Prototypen und der Erprobung dieser Technologie.

Mit Aleph Alpha habt ihr die Möglichkeit, fortschrittliche KI-basierte Lösungen zu entwickeln und damit eure Geschäftsprozesse zu optimieren sowie eure Kundschaft besser zu bedienen. Die Anwendungen von Natural Language Processing sind vielfältig und bieten in vielen Branchen enorme Potenziale. Ich bin überzeugt davon, dass Aleph Alpha eine wichtige Rolle bei der Weiterentwicklung dieser Technologie und der Förderung der europäischen KI-Industrie spielen wird.

Ich freue mich auf eine mögliche Zusammenarbeit mit euch und darauf, gemeinsam mit euch innovative Lösungen zu entwickeln und so einen Beitrag zur digitalen Transformation zu leisten.